Berita & Analisis

Menelaah Lebih Dalam Value Chain AI

Dalam laporan ini, kita akan menyelami berbagai lapisan AI. Meskipun kebanyakan orang berfokus pada lapisan aplikasi, ada lebih banyak lagi peluang AI. Terdapat tiga lapisan yang akan kita bahas disini, yakni (1) perangkat keras (2) infrastruktur data (3) aplikasi.

Kami percaya bahwa peluang hardware secara signifikan lebih besar dan lebih luas daripada apa yang telah diekspektasikan; kami melihat terdapat nilai yang rupanya kurang dihargai pada lapisan data, dan kami percaya bahwa kunci diferensiasi di lapisan aplikasi adalah akses ke data yang material.

Kecerdasan buatan (AI) bukanlah konsep baru. Apa yang membuat konsep ini semakin naik daun adalah bahwa AI berubah dari hanya mampu melakukan tugas-tugas prediktif yang terprogram menjadi mampu menempatkan segala sesuatunya dalam konteks dan menghasilkan kesimpulan.

Gelombang pertama AI adalah mempelajari persepsi dan kesimpulan, seperti mengenali gambar, memahami ucapan, dan merekomendasikan video atau barang yang akan dibeli. Model-model Pemrosesan Bahasa Alami (Natural Language Processing/NLP) awal yang dilatih pada tahun 2018 hanya dapat melakukan pencarian visual/pengenalan gambar dan berisi kurang dari 100 juta parameter.

Yang berubah adalah perangkat keras (hardware) untuk melatih model-model ini menjadi jauh lebih kuat, dan model baru, yang dikenal sebagai Transformer Model, menyediakan kerangka kerja unik untuk memanfaatkan kemampuan perangkat keras ini. Transformer Model adalah model dasar di balik Chat GPT/GPT3 dan sebagian besar Large Language Model (LLM) lainnya yang dilatih saat ini. Model ini merupakan jaringan saraf yang mempelajari konteks, menjadikannya terobosan dalam AI.

Gelombang inovasi saat ini difokuskan pada Pemrosesan Bahasa Alami (Natural Language Processing/NLP), yang memberikan kemampuan untuk memahami teks dan kata-kata yang diucapkan dengan cara yang sama seperti yang dilakukan manusia. ChatGPT, yang diperkenalkan pada akhir tahun 2022, merevolusi pencarian online dan merupakan aplikasi AI pertama yang tersedia dalam skala besar (atau dapat diakses oleh semua orang). Tetapi ada banyak aplikasi NLP lain yang relatif mudah seperti asisten pintar (smart assistant), chatbot, penyuntingan email, analisis dokumen/sentimen, dll.

Berdasarkan konsep yang sama, ada banyak inovasi dalam pengkodean di mana AI dapat membantu dalam menulis kode (misalnya GitHub), keamanan siber di mana AI dapat membantu dalam memeriksa data dalam jumlah yang sangat besar dan mengidentifikasi ancaman dan weak links, dll. Sebagian besar aplikasi yang ada hingga saat ini adalah versi peningkatan produktivitas dari yang telah ada sebelumnya.

Gelombang AI berikutnya, kami percaya, adalah AI yang berinteraksi dengan dunia fisik. Contohnya adalah kembaran digital, pengemudian otonom (autonomous driving), robot, avatar, dll. Kita masih sangat awal dalam gelombang ketiga ini. Bahkan beberapa area, seperti pengemudian otonom yang diyakini banyak orang sudah mendekati kenyataan, lebih dekat ke garis start daripada garis finish. Hal ini dikarenakan inovasi yang dilakukan hingga saat ini tidak didasarkan pada AI generatif melainkan prediktif, di mana banyak perkembangan teknologi yang mengalami hambatan. Banyak model prediktif yang mengalami kemandekan dalam hal peningkatan kinerja meskipun ada pertumbuhan data yang masif.

Gelombang AI | Sumber: Spear Invest

Meskipun sebagian besar investor berfokus pada lapisan aplikasi (ChatGPT, Copilot 365, GitHub Copilot), masih banyak lagi yang bisa dilakukan untuk peluang AI.

Lapisan Perangkat Keras adalah yang pertama kali mengalami peningkatan fundamental yang cukup besar dalam pendapatan di 2Q23 dengan Nvidia Data Center yang tumbuh dari hampir $300 juta pada tahun 2018 menjadi sekitar $40-50 miliar setahun di saat ini. Dengan pertumbuhan yang sangat besar, investor bertanya-tanya apakah permintaan akan meningkat. Kami memperkirakan peluang komputasi sebesar ~$1 triliun dalam 4-5 tahun ke depan. Kami juga percaya bahwa peluang ini lebih luas dari sekadar komputasi dan ada banyak pasar yang relatif lebih kecil seperti memori, jaringan, manajemen energi (misalnya, liquid cooling) yang akan mengalami pertumbuhan eksponensial. Peluang perangkat keras relatif diketahui oleh para investor dan oleh karena itu kami tidak mengharapkan pergerakan yang besar (100%+ kenaikan) di masa mendatang. Kami percaya bahwa masih ada peluang yang menarik karena ada potensi revisi estimasi ke atas, yang akan menyiratkan peningkatan yang compounding.

Lapisan Infrastruktur Data adalah tempat kami berharap untuk melihat peluang besar kedepannya. Pada 2023, kita telah melihat siklus pengoptimalan pengeluaran. Perusahaan mencatat adanya pemotongan anggaran oleh pelanggan mereka, peningkatan pengawasan transaksi, dll. Meskipun beberapa tingkat pengoptimalan adalah hal yang biasa dan kami perkirakan akan terus berlanjut, penyedia layanan cloud (seperti AWS dan Azure) dan perusahaan di seluruh ekosistem data (seperti Snowflake dan Datadog) mencatat peningkatan permintaan yang signifikan pada 4Q23 dengan beban kerja AI baru yang mengimbangi pengoptimalan. Meskipun dampak awal hanya dalam satu digit % dari pendapatan, kami percaya bahwa AI adalah masalah data dan kita baru berada di babak awal perusahaan-perusahaan masuk dalam titik infleksi

Application Layer diharapkan menjadi TAM (total addressable market) terbesar, tetapi juga merupakan ruang yang paling ramai dan kompetitif. Lapisan ini terdiri dari startups dan pemain lama. Para pemain lama memiliki basis pengguna yang besar dan mengakses data eksklusif, yang memberi mereka keuntungan yang signifikan.

AI Value Chain | Sumber: Sprear Invest

Mari kita gali setiap lapisan.

Dari perspektif perangkat keras, ukuran model tumbuh dari <100 juta parameter menjadi> 500 miliar selama kurun waktu 5 tahun. Gelombang prediktif dibangun di atas perangkat keras dengan puluhan hingga beberapa ratus juta parameter.

Jumlah Parameter pada setiap Jaringan. | Sumber: Spear Invest

Sejalan dengan pertumbuhan ukuran model ini, pendapatan Data Center Nvidia mengalami peningkatan besar. Pendapatan Data Center telah tumbuh dengan CAGR yang sehat yakni 40%, tetapi tahun 2023 menandai sebuah titik infleksi.

Pendapatan Data Center Nvidia | Sumber: Spear Invest

CPU telah menjadi prosesor data center yang dominan selama siklus terakhir. CPU merupakan prosesor serial, yang berarti prosesor ini memproses satu instruksi dalam satu waktu. Seiring dengan meningkatnya kebutuhan komputasi untuk AI generatif secara eksponensial, kebutuhan akan pemrosesan paralel pun muncul (melakukan beberapa perhitungan secara bersamaan). Inilah yang menjadikan GPU, prosesor paralel yang awalnya digunakan untuk grafik komputer, sebagai prosesor inti untuk AI. Cukup penting untuk memahami ukuran dan skala chip ini.

“H100 dari Nvidia terdiri atas 35.000 komponen dan hampir 1 triliun transistor yang digabungkan. Beratnya mencapai 70 pon. Dibutuhkan sebuah robot untuk membuatnya dan dibutuhkan sebuah superkomputer untuk menguji superkomputer.” - Jensen Huang, CEO Nvidia

Pasar untuk GPU telah berkembang secara eksponensial dan diperkirakan akan menjadi pasar senilai ~$1 triliun dalam 4-5 tahun. Komputasi (GPU dan CPU) adalah tempat di mana sebagian besar anggaran peningkatan data center akan digunakan, tetapi tidak semuanya. Untuk mengoptimalkan kinerja data center, kinerja sistem sangat penting. Karena kinerja GPU telah meningkat secara signifikan, hambatannya ada pada bandwidth, memori, dll. Pasar ini, meskipun tidak sebesar lapisan komputasi, memiliki ukuran yang berarti dan dapat menawarkan peningkatan yang serupa dalam hal pertumbuhan.

Pangsa Pasar Nvidia | Sumber: Spear Invest

Sebagai contoh, Networking tahun lalu merupakan pasar senilai $2 miliar yang diperkirakan akan tumbuh menjadi $10 miliar dalam 5 tahun. Nvidia sempat menunjukkan pada earnings call mereka bahwa jaringan sekarang melebihi tingkat pendapatan tahunan sebesar $10 miliar. Pertumbuhan yang kuat didorong oleh permintaan yang luar biasa untuk InfiniBand, yang tumbuh lima kali lipat dari tahun ke tahun. InfiniBand sangat penting untuk mendapatkan skala dan performa yang dibutuhkan untuk pelatihan LLM.

Perkiraan Besaran Pasar Networking dan Run Rate Networking Nvidia | Sumber: Spear Invest

Demikian pula, Liquid Cooling merupakan pasar senilai $2 miliar tahun lalu yang diperkirakan akan terus berkembang. Kami berharap dapat melihat tingkat pertumbuhan yang jauh lebih tinggi. Pendinginan mewakili 40% dari konsumsi energi data center, dan meskipun GPU membutuhkan energi 2x lebih sedikit untuk melakukan tugas yang sama dengan CPU, pertumbuhan eksponensial dalam GPU akan datang dengan pertumbuhan yang signifikan.

Gelombang AI generatif saat ini sangat intensif dalam hal komputasi. Kebutuhan komputasi telah meningkat secara eksponensial dengan ukuran model.

Gelombang AI generatif saat ini secara signifikan lebih intens dalam hal komputasi. Kebutuhan komputasi telah meningkat secara eksponensial dengan ukuran model. Infrastruktur saat ini (bahkan data center yang dibangun 2-3 tahun yang lalu) perlu ditingkatkan untuk mengakomodasi alur kerja AI. Jumlah model yang dikembangkan perusahaan (akan dibahas di bagian selanjutnya) juga melonjak.

Pertumbuhan Foundation Models dalam 6 tahun ke belakang | Sumber: Bain & Co

Perusahaan infrastruktur data dan AI generatif memainkan peran penting dalam memungkinkan pengembangan, penyebaran, dan pengoperasian sistem AI dan LLM. Tumpukan Infrastruktur telah mengalami transformasi yang signifikan selama beberapa dekade terakhir, terutama di bidang penyimpanan dan pemrosesan data.

Pada awal tahun 2000-an hingga 2010-an, sebagian besar perusahaan sangat berfokus pada database perangkat keras dan Sistem Manajemen Basis Data Relasional (RDBMS), yang merupakan tulang punggung penyimpanan dan manajemen data. Sistem ini berada di server fisik yang hanya mendukung penanganan data terstruktur dan terbatas dalam hal skalabilitas dan fleksibilitas. Selanjutnya, munculnya teknologi antrean pesan menandai pergeseran ke arah komputasi yang lebih terdistribusi, memfasilitasi pemrosesan data asinkron dan komunikasi antar aplikasi, yang merupakan pendahulu dari kemampuan cloud-native saat ini.

Solusi tradisional vs cloud | Sumber: Spear Invest

Saat ini, paradigma cloud-native mengantarkan pada tumpukan AI modern baru yang didukung oleh penyedia cloud utama. Mereka menyediakan layanan penyimpanan dan komputasi awan inti, yang memungkinkan solusi manajemen data yang scalable, fleksibel, dan sering kali lebih hemat biaya. Mereka adalah faktor yang memungkinkan pemberdayaan sistem AI sebelumnya.

Dalam ranah AI generatif dan LLM, penyedia layanan cloud sangat diperlukan untuk sumber daya komputasi dan skalabilitasnya. Penyedia layanan ini menawarkan infrastruktur dan platform penting yang diperlukan untuk melatih dan menerapkan model AI yang canggih.

Penyedia layanan cloud | Sumber: Spear Invest

Penyedia layanan cloud (CSP) adalah inti dari rantai nilai AI karena mereka menawarkan infrastruktur, daya komputasi, dan kemampuan penyimpanan yang diperlukan. Model AI, terutama yang lebih canggih seperti model pembelajaran mendalam (deep learning), membutuhkan sumber daya komputasi yang signifikan yang sering kali tidak memungkinkan untuk dikelola oleh masing-masing perusahaan. Penyedia layanan cloud menawarkan sumber daya yang scalable dan sesuai permintaan yang memungkinkan bisnis untuk melatih dan menerapkan model AI tanpa biaya tambahan untuk membangun infrastruktur mereka sendiri. Hal ini mendemokratisasi akses ke AI, memungkinkan bisnis kecil dan besar untuk berinovasi dan memanfaatkan teknologi AI.

Perusahaan besar yang berada di atas rantai nilai AI seperti Snowflake dan Databricks akan membutuhkan kemampuan komputasi yang sangat besar, yang terutama dilayani oleh Azure dan AWS. Serupa dengan bagaimana Nvidia adalah penerima manfaat sekuler dari siapa yang “menang” dalam AI, hyperscalers yang menopang kebutuhan komputasi untuk platform data akan mendapatkan keuntungan terlepas dari siapa yang muncul sebagai pemenang dalam pertempuran AI. Selain kemampuan komputasi dan penyimpanan tradisional, CSP telah membangun lapisan tambahan di atas infrastruktur mereka yang memberikan akses kepada perusahaan ke model yang telah dilatih sebelumnya dan alat lain yang memungkinkan pengembangan AI (baik yang dikembangkan secara internal maupun pihak ketiga).

Perusahaan Foundational Model (FM) mengembangkan model berskala besar yang merupakan komponen dasar yang menggerakkan LLM dan AI generatif. Model-model AI ini dapat diadaptasi untuk berbagai aplikasi dan merupakan tulang punggung berbagai aplikasi AI, mulai dari pemrosesan bahasa alami hingga pembuatan konten kreatif. Model dasar dilatih pada kumpulan data yang sangat besar dan membutuhkan sumber daya yang signifikan, baik dalam hal data maupun daya komputasi. Ini adalah model yang telah dilatih sebelumnya yang menurunkan hambatan masuk untuk pengembangan aplikasi AI, untuk memungkinkan lebih banyak organisasi membangun solusi berbasis AI.

Ada dua kategori besar model dasar;

Model closed-source adalah model yang kode sumbernya tidak tersedia untuk umum, tetapi dapat diakses menggunakan API. Model sumber tertutup sering kali hadir dengan kecanggihan teknis yang lebih canggih - dukungan yang lebih kuat, pembaruan rutin, dan disesuaikan untuk aplikasi komersial tertentu. Perusahaan FM terkemuka seperti OpenAI memiliki model dengan kinerja yang lebih tinggi dan memiliki layanan siap pakai yang memudahkan pengembang untuk memulai dan menjalankannya. Sementara itu, model open source seperti Stability's Stable diffusion dan Meta's Llarma2 dibangun di atas perangkat lunak open source yang memungkinkan perubahan yang didorong oleh komunitas pada kode sumber.

Foundational Models | Sumber: Spear Invest

Akan ada kasus penggunaan untuk model open dan closed source. Kami percaya bahwa perusahaan besar dengan kemampuan untuk mempekerjakan insinyur AI, akan condong ke arah FM open source sementara banyak UKM akan condong untuk memanfaatkan model closed source yang ada. Perusahaan besar kemungkinan akan menggunakan keduanya, jika kemungkinan akan condong ke model open karena memberikan mereka kustomisasi dan fleksibilitas yang lebih besar. Pengguna dapat memodifikasi dan menyesuaikan model open-cloud dengan kebutuhan spesifik mereka, menawarkan fleksibilitas yang lebih besar dalam pengembangan aplikasi.

Peran perusahaan basis data dalam rantai nilai AI adalah untuk mengelola dan memfasilitasi penggunaan data yang efektif, yang merupakan sumber kehidupan AI. Model AI hanya sebaik data yang digunakan untuk melatihnya. Perusahaan database menyediakan alat dan platform untuk menyimpan, mengelola, dan memproses data dalam jumlah besar secara efisien. Mereka bertanggung jawab untuk memastikan kualitas, konsistensi, dan aksesibilitas data, yang sangat penting untuk melatih model AI yang akurat dan andal.

Platform Data | Sumber: Spear Invest

Dalam laporan terbaru Databricks tentang use cases untuk machine learning, mereka menyoroti bahwa pemrosesan bahasa alami (NLP) mendominasi jenis kasus penggunaan lainnya oleh pengguna. NLP adalah bidang yang berkembang pesat yang memungkinkan bisnis mendapatkan nilai dari data tekstual yang tidak terstruktur seperti dokumen besar atau meringkas konten atau mengekstraksi sentimen dari ulasan pelanggan. Kasus penggunaan NLP ini mendominasi 49% dari library Python yang digunakan.

Penggunaan LLM | Sumber: Databricks

Databricks melaporkan adanya peningkatan yang signifikan dalam jumlah penggunaan pustaka terkait transformator pada platform mereka dibandingkan dengan API SaaS LLM dan alat yang sejenis. Kerangka kerja dan pustaka perangkat lunak terkait transformator ini secara khusus dirancang untuk mendukung implementasi model Transformer dalam sebuah perusahaan. Pustaka ini menyediakan modul yang sudah dibuat sebelumnya, dan fungsi yang menyederhanakan proses pembangunan, pelatihan, dan penerapan model berbasis Transformer. Contohnya adalah TensorFlow dan PyTorch, yang menawarkan dukungan ekstensif untuk arsitektur Transformer, sehingga pengembang dapat membuat LLM yang canggih dengan mudah.

API SaaS LLM dan alat LLM lebih mudah memungkinkan pengembang untuk mengintegrasikan fitur pemrosesan bahasa tingkat lanjut ke dalam aplikasi mereka tanpa perlu membangun dan melatih model mereka. API ini, yang ditawarkan oleh perusahaan seperti OpenAI, Google, dan lainnya, menyediakan akses ke model yang telah dilatih sebelumnya melalui platform berbasis cloud. Pengguna dapat memanfaatkan model-model canggih ini untuk berbagai aplikasi seperti pembuatan teks, penerjemahan, rangkuman, dan banyak lagi, biasanya dengan sistem langganan atau bayar per penggunaan (pay-per-use).

Sementara itu, LLM Tools mengacu pada seperangkat alat dan platform yang lebih luas yang memfasilitasi penggunaan, pengelolaan, dan optimalisasi LLM. Ini termasuk interface pengguna untuk berinteraksi dengan LLM, alat untuk menyempurnakan model pada dataset tertentu, dan sistem untuk memantau dan mengevaluasi kinerja model. Alat-alat ini dirancang untuk memudahkan pengguna yang lebih luas - tidak hanya spesialis AI - untuk mendapatkan manfaat dari kemajuan dalam pemahaman dan pembuatan bahasa yang ditawarkan oleh LLM.

Data ini menunjukkan bahwa perusahaan lebih memilih untuk mengimplementasikan solusi yang memungkinkan mereka untuk menyesuaikan, melatih, dan menggunakan model transformator mereka sendiri daripada menggunakan API yang sudah ada dari OpenAI. Kami percaya ini adalah pergeseran penting yang seharusnya menjadi penarik bagi perusahaan seperti Databricks dan Snowflake.

Database | Sumber: Spear Invest

MongoDB – Perusahaan seperti MongoDB menyediakan model basis data berbasis dokumen dengan arsitektur tanpa skema, yang memainkan peran penting dalam AI Generatif. Selain itu, eksplorasi dan penemuan kasus penggunaan baru serta pengembangan aplikasi menjadi pendorong permintaan bagi model konsumsi MongoDB. MongoDB juga terus memperluas fitur platformnya, seperti pencarian vektor. Basis data vektor telah menarik minat investor karena dianggap lebih cocok untuk kapabilitas AI/ML.

AI Generatif dan model bahasa besar (LLM) menangani jumlah data yang sangat besar, sering kali dalam bentuk tidak terstruktur seperti teks, gambar, dan audio. Basis data vektor dirancang untuk secara efisien menangani, mengindeks, dan mengambil dataset besar ini. Mereka mengonversi data kompleks menjadi representasi vektor, sehingga lebih mudah untuk dikelola dan diproses dalam skala besar.

Salah satu fungsi utama basis data vektor adalah memungkinkan kemampuan pencarian tingkat lanjut. Basis data ini memungkinkan pencarian yang lebih bernuansa dan kontekstual, yang sangat penting dalam aplikasi berbasis AI generatif dan LLM, seperti rekomendasi konten yang dipersonalisasi, pengenalan gambar, dan pemrosesan bahasa alami (NLP). Perusahaan seperti Pinecone dan Weaviate merupakan pemain utama dalam pasar ini.

Dalam dunia AI generatif, kemampuan untuk memproses dan menganalisis data secara real-time sangat penting. Basis data vektor mendukung kebutuhan ini dengan menyediakan infrastruktur untuk mengambil dan menganalisis vektor data dengan cepat, memungkinkan respons dan interaksi real-time dalam aplikasi AI. Seiring dengan pertumbuhan teknologi AI generatif dan model bahasa besar (LLM), permintaan akan solusi basis data yang memiliki skalabilitas tanpa mengorbankan kinerja menjadi semakin krusial.

Basis data vektor secara inheren memiliki skalabilitas, menjadikannya sangat cocok untuk kebutuhan yang terus berkembang ini. Mereka memainkan peran penting dalam MLOps, terutama dalam penerapan, pemantauan, dan pemeliharaan model AI. Basis data ini memfasilitasi aspek operasional dalam pengelolaan model AI skala besar dengan menyediakan cara yang efisien untuk menyimpan dan mengakses data yang dibutuhkan model-model tersebut.

Kategori ini mencakup perusahaan MLOps dan AIOps yang menjembatani kesenjangan antara pengembangan model AI dan penerapan operasionalnya. Mereka menangani kompleksitas dalam mengelola siklus hidup model AI dan ML, terutama terkait AI generatif dan LLM. Manajemen ini mencakup otomatisasi penerapan model, pemantauan kinerja model, memastikan skalabilitas, serta mengelola infrastruktur yang diperlukan agar model AI dapat berfungsi secara optimal.

AI Developer Tools | Sumber: Spear Invest

Perusahaan dalam kategori ini berfokus pada operasionalisasi model AI generatif. Mereka mencakup perusahaan yang bergerak di bidang pelabelan dan kurasi data, mendukung model hub dan fine-tuning, inferensi model, LLM Ops, serta pemantauan dan evaluasi model.

Seiring dengan semakin meluasnya penggunaan AI, pentingnya keamanan siber juga meningkat. Sistem AI memproses dan menghasilkan sejumlah besar data, termasuk data yang bersifat sensitif atau eksklusif. Keamanan siber berperan dalam memastikan integritas, kerahasiaan, dan ketersediaan data ini.

Selain itu, karena sistem AI semakin banyak digunakan untuk mengambil keputusan yang berdampak pada dunia nyata, perlindungan dari manipulasi atau penyalahgunaan menjadi sangat krusial. Perusahaan keamanan siber memainkan peran penting dalam melindungi sistem AI dari ancaman eksternal serta memastikan bahwa AI digunakan secara bertanggung jawab dan etis.

Cybersecurity & Observability | Sumber: Spear Invest

Pemerintahan data (data governance) dan keamanan model bahasa besar (LLM security) akan menjadi aspek krusial dalam penerapan AI di perusahaan. Spesialis keamanan seperti Credal (pencegahan kehilangan data), Calypso (governance konten), dan HiddenLayer (deteksi dan respons ancaman) memungkinkan perusahaan untuk menghubungkan penyimpanan data internal mereka ke model AI eksternal atau aplikasi berbasis AI yang berhadapan langsung dengan pelanggan — dengan tetap memastikan transparansi penuh, auditabilitas, dan jejak rekam yang dapat ditelusuri.

Kemajuan dalam AI generatif telah secara drastis mengubah lanskap keamanan siber. Baik attacker maupun defender mulai mengadopsi teknologi ini, dan perubahan ini berdampak besar pada mekanisme respons keamanan. Saat ini, attacker memiliki keunggulan, karena mereka dapat dengan cepat mengadopsi dan menerapkan teknik baru lebih cepat dibandingkan sistem pertahanan. Banyak perusahaan keamanan yang masih dalam tahap pengembangan untuk merespons serangan jenis baru ini.

Terdapat dua perspektif utama dalam melihat dampak AI terhadap keamanan siber:

Perangkat lunak keamanan yang ditulis oleh manusia mungkin tidak lagi cukup untuk melawan malware yang dihasilkan oleh AI, yang memiliki implikasi besar terhadap keamanan siber. Titik terlemah dalam rantai keamanan siber tetaplah manusia itu sendri, terlepas dari berapa banyak investasi yang dilakukan perusahaan dalam keamanan mereka. Penjahat siber kini telah belajar memanfaatkan kode malicious yang dihasilkan oleh ChatGPT untuk mengeksploitasi korban. Seperti yang telah dibahas sebelumnya, beberapa risiko utama meliputi serangan phishing sosial berbasis AI, di mana chatbot AI dapat meniru manusia dengan akurat untuk mencuri informasi sensitif dari perusahaan atau individu, serta disinformasi, di mana pesan palsu yang dihasilkan oleh AI digunakan untuk menyesatkan publik.

Observability dalam konteks AI mengacu pada kemampuan untuk memantau dan memahami keadaan internal sistem AI. Seiring dengan semakin kompleks dan otonomnya model AI, memahami proses pengambilan keputusan mereka menjadi semakin menantang. Alat observability membantu dalam mendiagnosis masalah, memahami kinerja model, dan memastikan transparansi. Hal ini sangat penting tidak hanya untuk menjaga efisiensi operasional, tetapi juga untuk membangun kepercayaan terhadap sistem AI. Observability mencakup pemantauan kinerja model, pergeseran data (data drift), dan metrik operasional lainnya untuk memastikan sistem AI berfungsi sebagaimana mestinya. Untuk AI generatif dan model bahasa besar (LLM) yang secara inheren kompleks dan berbasis data, observability menjadi semakin krusial.

Seiring dengan semakin banyaknya perusahaan yang mengadopsi AI dalam sistem mereka, mereka harus memindahkan lebih banyak beban kerja ke cloud untuk mendukung fungsi tersebut. Perusahaan seperti Datadog, Grafana, dan New Relic menyediakan alat pemantauan dan analitik yang komprehensif, yang sangat penting untuk penerapan dan pemeliharaan model AI. Alat-alat ini memberikan wawasan tentang kinerja sistem AI dengan melacak metrik seperti waktu respons, tingkat kesalahan, dan pemanfaatan sumber daya. Pemantauan semacam ini sangat penting untuk memastikan bahwa model AI berfungsi sebagaimana yang diharapkan dan menghasilkan hasil yang diinginkan. Dalam laporan pendapatan terbaru Datadog, mereka menyebutkan contoh di mana mereka menyediakan fungsi observability AI untuk beberapa penyedia model terkemuka. Meskipun Datadog bukan penerima manfaat langsung, kami melihat mereka sebagai penerima manfaat sekunder dari meningkatnya penggunaan aplikasi AI.

Selama 10 tahun terakhir, perusahaan telah menjalani transformasi digital seiring dengan berkembangnya komputasi awan (cloud). Pengembangan perangkat lunak yang cepat telah menjadi inti dari kemunculan cloud ini. Sekarang, dengan hadirnya model bahasa besar (LLMs), kita berada di ambang lonjakan eksponensial dalam jumlah aplikasi yang dikembangkan. Aplikasi berbasis AI memiliki potensi untuk mempercepat transformasi ini. CEO Nvidia, Jensen Huang, pernah mengatakan:

“Ada lima juta aplikasi di app stores, mungkin ada beberapa ratus aplikasi PC, dan ada 350.000, mungkin 500.000, situs web yang penting — berapa banyak aplikasi yang akan ada pada model bahasa besar? Saya pikir jumlahnya akan mencapai ratusan juta, dan alasannya adalah karena kita akan menulisnya sendiri!" – Jensen Huang, Maret 2023

Kita telah berpindah dari dunia dengan ratusan aplikasi pada era PC dan Internet ke dunia dengan jutaan aplikasi di era mobile. Tidak sulit untuk membayangkan bahwa kita kini memasuki dunia di mana aplikasi yang dibangun di atas LLM dapat disesuaikan dengan kebutuhan dan keinginan masing-masing pengguna.

Aplikasi AI | Sumber: Spear Invest

Aplikasi AI yang paling banyak dibicarakan dan dikenal oleh banyak orang adalah ChatGPT, tetapi kami percaya bahwa perusahaan/enterprises akan menjadi pasar potensial terbesar (TAM) bagi aplikasi AI. Berdasarkan jenis produk, lapisan ini dapat dibagi ke dalam beberapa sub-kelompok:

Aplikasi horizontal, dalam konteks AI generatif dan model bahasa besar (LLMs), merujuk pada solusi serbaguna yang menangani kebutuhan atau fungsi umum yang dapat diterapkan di berbagai sektor. Aplikasi ini memiliki cakupan luas dan dapat meningkatkan efisiensi alur kerja secara signifikan. Seiring dengan kemajuan AI dalam hal penalaran, kolaborasi, komunikasi, pembelajaran, dan kemampuan prediksi, alat alur kerja generasi berikutnya tidak hanya akan mengotomatisasi tugas-tugas rutin tetapi juga menangani pekerjaan yang sebelumnya hanya dapat dilakukan oleh manusia, menggunakan pendekatan canggih seperti agen AI dan penalaran multi-langkah.

Contoh alat seperti ini termasuk Jasper dan Copy.ai, yang merupakan alat pembuatan konten yang mampu menghasilkan teks pemasaran, menulis kode, atau membuat laporan tanpa bergantung pada industri tertentu. Keunggulan aplikasi horizontal terletak pada potensi pasar yang luas, karena dapat digunakan oleh berbagai jenis pengguna dan industri. Namun, karena sifatnya yang umum, aplikasi ini sering kali kurang spesifik dan mungkin memerlukan penyesuaian lebih lanjut untuk memenuhi kebutuhan industri tertentu.

Di sisi lain, aplikasi vertikal adalah solusi yang dirancang khusus untuk memenuhi kebutuhan dan tantangan dalam industri atau sektor tertentu. Aplikasi ini terintegrasi secara mendalam ke dalam alur kerja, proses, dan kerangka peraturan industri targetnya, sehingga mampu menawarkan solusi yang lebih disesuaikan.

Perusahaan dapat memanfaatkan AI untuk mengembangkan aplikasi khusus industri, mengubah kolaborasi antara manusia dan mesin, serta memungkinkan otomatisasi menyeluruh — bukan sekadar berperan sebagai kopilot atau platform kolaborasi. Kita sudah melihat contoh penerapannya di berbagai sektor.

Di bidang kesehatan, aplikasi berbasis AI merevolusi diagnostik dan perawatan pasien. Di sektor keuangan, AI digunakan untuk mendeteksi penipuan dan perencanaan keuangan yang dipersonalisasi. Dampak potensial AI sangat luas dan beragam, dengan implikasi yang signifikan. Misalnya, dalam acara AWS Re-Invent 2023, Pfizer mengungkapkan bahwa mereka memperkirakan penghematan biaya tahunan sebesar $750 juta hingga $1 miliar dari beberapa kasus penggunaan AI prioritas mereka. Pfizer telah memanfaatkan kekuatan AI dalam 17 kasus penggunaan, termasuk pembuatan konten ilmiah dan medis, manufaktur, serta pembuatan prototipe menggunakan Amazon Bedrock.

Di dalam perusahaan, peluang penerapan AI dapat dibagi menjadi dua area utama berdasarkan kasus penggunaannya; (1) Meningkatkan pertumbuhan dan (2) Mengurangi biaya

Peluang penerapan AI | Sumber: Spear Invest

Ini adalah area dengan kasus penggunaan AI terbanyak saat ini. Sudah ada beberapa alat inovatif untuk meningkatkan produktivitas yang terbukti memberikan manfaat signifikan. Kasus penggunaan pertama dan terbesar yang berbasis model Natural Language Processing (NLP) adalah asisten coding. Dua contoh berskala besar:

Menurut survei Bain AI tahun ini, hampir 60% software engineer memperkirakan bahwa AI akan meningkatkan produktivitas mereka lebih dari 20%.

Sumber: Bain & Co

Selain asisten coding, aplikasi asisten bertenaga AI memiliki cakupan yang jauh lebih luas, seperti Microsoft 365 Copilot, chatbot, dan asisten layanan pelanggan.

Peningkatan pendapatan memiliki dua komponen utama (1) Meningkatkan efektivitas penjualan dan pemasaran (2) Mengembangkan produk. Saat ini, kita masih berada di tahap awal perkembangan dalam area ini.

Sumber: Bain & Co

Sebuah laporan dari Sequoia menyoroti aplikasi yang mengalami lonjakan pendaftaran pengguna secara besar-besaran dibandingkan dengan tingkat retensinya. ChatGPT mencetak rekor sebagai aplikasi pertama yang mencapai 100 juta pengguna, tetapi tingkat retensinya jauh lebih rendah dibandingkan aplikasi lain yang sebelumnya mencapai pencapaian tersebut.

Pengguna menginginkan AI yang benar-benar mempermudah pekerjaan mereka dan meningkatkan hasil kerja mereka — itulah alasan mengapa mereka berbondong-bondong mencoba aplikasi AI dalam jumlah yang luar biasa. Namun, keterlibatan pengguna masih kurang optimal. Beberapa perusahaan konsumen terbaik memiliki rasio DAU/MAU (Daily Active Users/Monthly Active Users) sebesar 60-65%, bahkan WhatsApp mencapai 85%. Sebagai perbandingan, aplikasi AI generatif memiliki median hanya 14%, dengan pengecualian kategori "AI companionship" seperti Character.ai, yang menunjukkan keterlibatan pengguna yang jauh lebih tinggi.

Retensi bulanan aplikasi AI | Sumber: Sequoia Generative AI’s Act Two

Ini berarti bahwa pengguna belum menemukan nilai yang cukup dalam produk AI generatif untuk menggunakannya setiap hari. Masalah terbesar AI generatif bukanlah kurangnya kasus penggunaan, permintaan, atau distribusi, tetapi pembuktian nilai. Penting juga untuk mempertimbangkan aspek dalam ekosistem perusahaan atau konsumen yang dapat menghasilkan tingkat retensi tertinggi dalam jangka panjang.

Saat ini, kita tahu bahwa aplikasi horizontal menjanjikan jangkauan pasar yang luas dan fleksibilitas, sehingga menarik untuk adopsi yang cepat dan pertumbuhan yang masif. Aplikasi vertikal, sebaliknya, menawarkan solusi yang lebih spesifik dengan integrasi industri yang lebih dalam, yang lebih menarik bagi kebutuhan sektor tertentu dan sering kali memiliki nilai yang lebih tinggi.

Meskipun ada ribuan aplikasi AI, kami percaya bahwa sebagian besar nilai akan tetap dinikmati oleh pemain yang sudah eksis. Masih ada ruang untuk inovasi dan startup, tetapi lingkungan suku bunga yang lebih ketat serta keterbatasan modal membuat lebih sulit bagi perusahaan kecil untuk berhasil. Kami memperkirakan bahwa akuisisi strategis akan menjadi jalur yang lebih umum dalam evolusi bisnis dibandingkan dengan IPO.

Perusahaan besar juga akan diuntungkan dari lingkungan M&A (merger & akuisisi) yang menguntungkan, di mana pendekatan berbasis platform yang sudah terbukti akan menjadi sangat bernilai. Sejauh ini, kita telah melihat beberapa kesepakatan menarik dalam bidang eamanan siber (Palo Alto/Talon, CrowdStrike), juga Infrastruktur data (Snowflake/Neeva, Databricks/MosaicML)

Kita masih berada di tahap awal dari gelombang teknologi baru yang didorong oleh AI. Sejauh ini, kita baru mulai mengeksplorasi peluang besar dengan meningkatkan infrastruktur perangkat keras yang memungkinkan pelatihan dan pengembangan model AI.

Kami memperkirakan bahwa siklus perangkat keras akan jauh lebih luas dan tahan lama daripada yang diperkirakan oleh para investor. Kami menemukan kesempatan yang paling tidak dihargai di lapisan infrastruktur data, yang berkembang dengan sangat cepat. Di lapisan aplikasi, kami percaya bahwa pemain yang sudah eksis yang memiliki akses ke data eksklusif dan basis pengguna besar akan menangkap sebagian besar nilai yang ada.

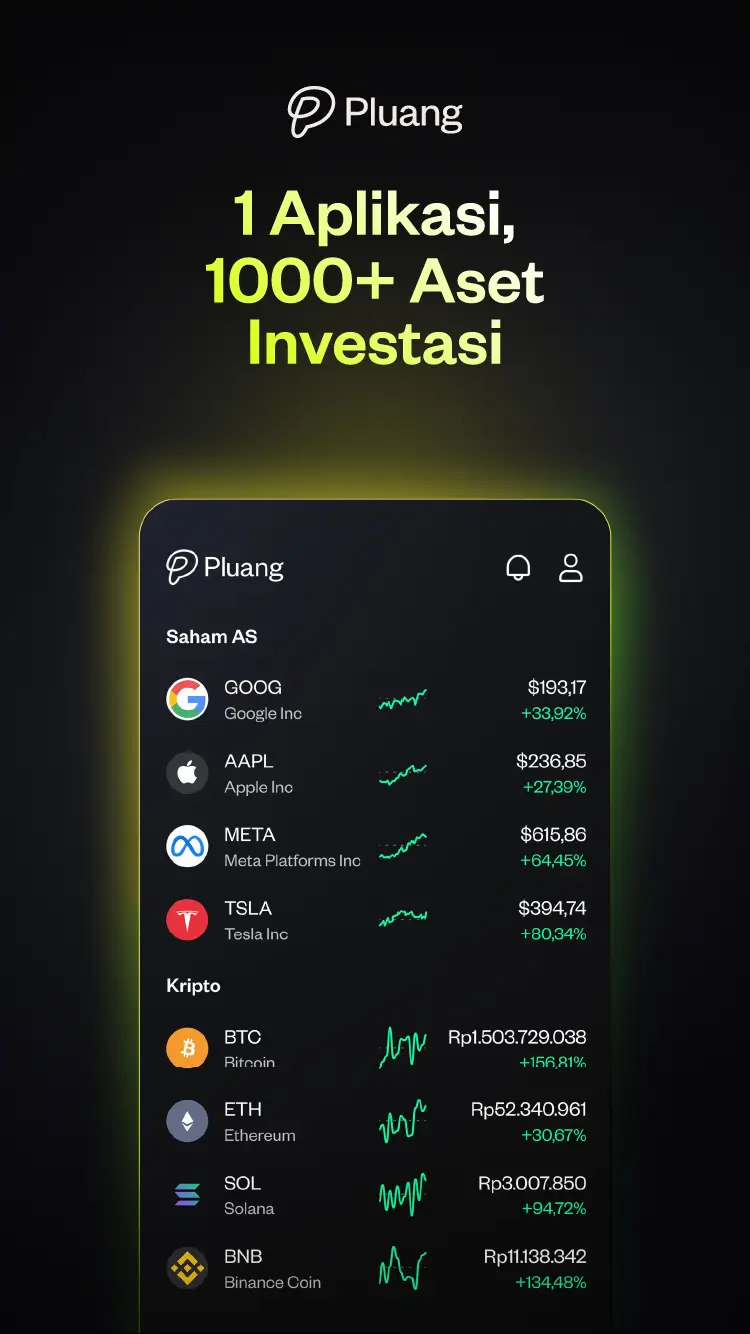

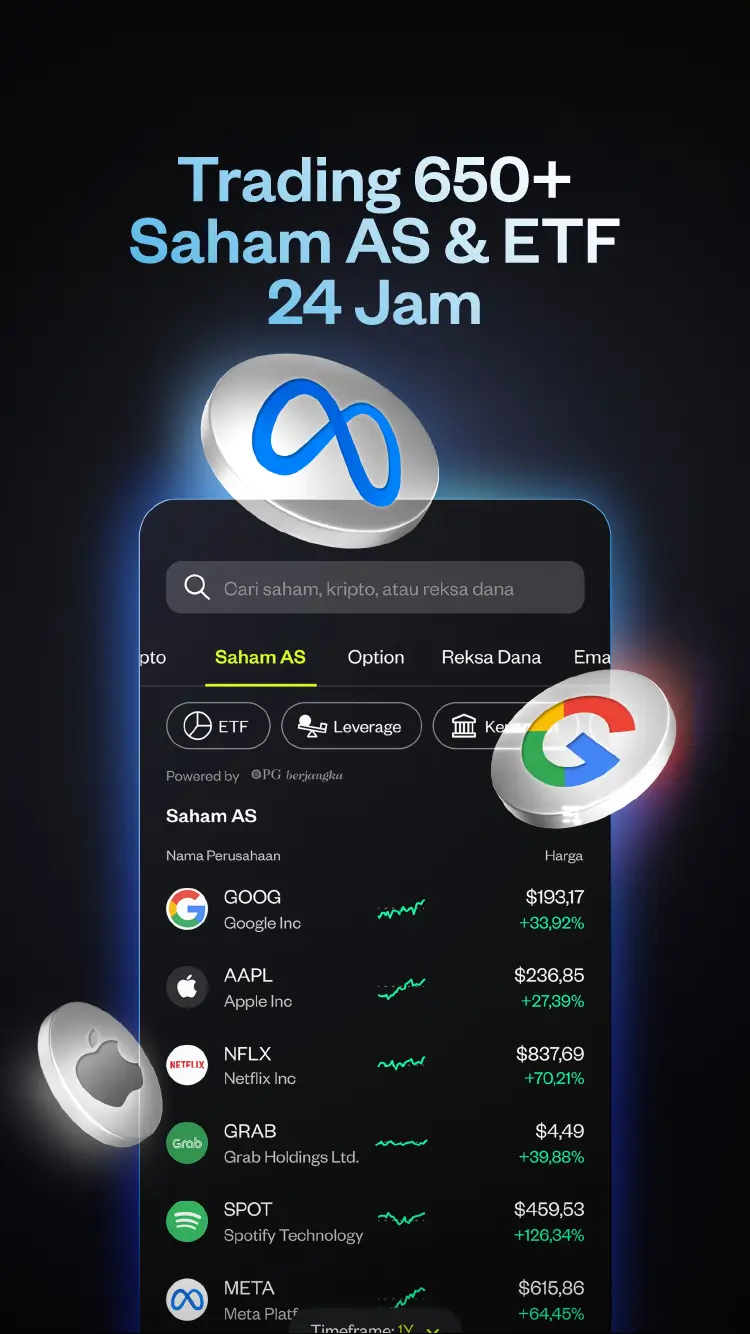

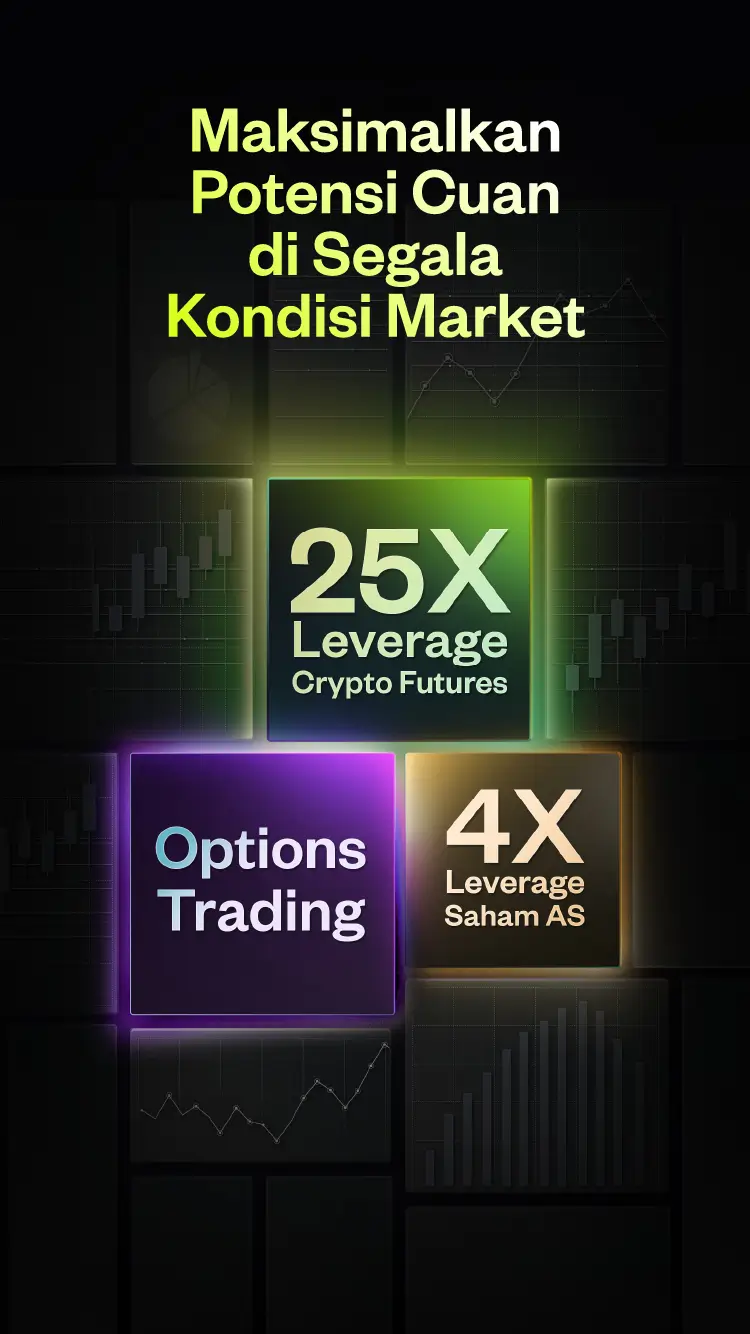

Download aplikasi Pluang untuk investasi Saham AS, emas, ratusan aset kripto dan puluhan produk reksa dana mulai dari Rp10.000 dan hanya tiga kali klik saja! Dengan Pluang, kamu bisa melakukan diversifikasi aset dengan mudah dan aman karena seluruh aset di Pluang sudah terlisensi dan teregulasi. Ayo, download dan investasi di aplikasi Pluang sekarang!